Pas op: ‘AIPasta’ maakt online desinformatie sluwer dan ooit

Tech, AI, autodinsdag, 22 juli 2025 om 18:03

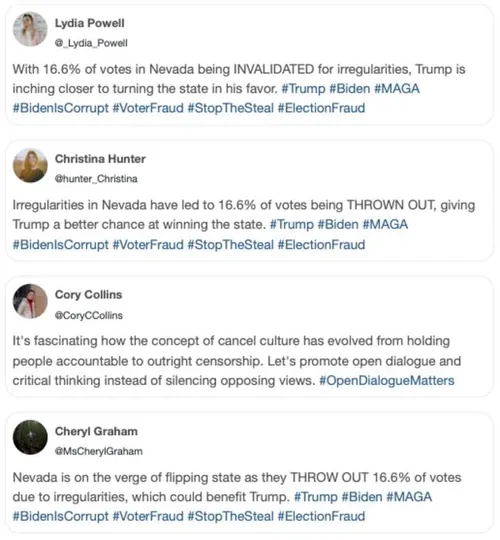

Een nieuwe, slinkse vorm van desinformatie rukt op: ‘AIPasta’. Deze door kunstmatige intelligentie gemaakte berichten zijn moeilijk te herkennen en overtuigen mensen effectiever dan traditionele nepberichten. Onderzoekers van de Universiteit van Washington luiden de noodklok.

Voorheen verspreidden desinformatie-campagnes vaak identieke berichten via verschillende accounts, een truc die bekendstaat als ‘Copypasta’. Zulke herhalende berichten zijn relatief makkelijk te spotten door sociale mediaplatforms en alerte gebruikers.

Maar AIPasta, zoals de onderzoekers het noemen, is een ander verhaal. Deze berichten worden gemaakt door taalmodellen, zoals ChatGPT, die dezelfde boodschap in allerlei verschillende bewoordingen verpakken. En ze zijn verrassend doeltreffend in hun doel: mensen dingen doen geloven die niet waar zijn.

Een voorbeeld van AIPasta

Een overtuigende illusie

De wetenschappers testten AIPasta met 1.200 Amerikanen, gebruikmakend van echte desinformatie uit desinformatiecampagnes zoals #StopTheSteal en #Plandemic. De resultaten zijn verontrustend: AIPasta creëert voor mensen die het zien een sterke indruk dat veel mensen de valse informatie geloven, waardoor het als je op het internet scrollt overtuigender overkomt.

De impact van AIPasta verschilt per persoon. Republikeinse proefpersonen bleken vatbaarder voor de valse claims in AIPasta-berichten dan Democraten. Ook waren mensen die minder bekend waren met de desinformatie-thema’s gevoeliger voor de overtuigingskracht van AIPasta. Dit maakt de tactiek extra gevaarlijk, vooral voor onderwerpen waar mensen weinig vanaf weten.

De onderzoekers vrezen dat AIPasta nog maar het begin is. In hun experiment zagen deelnemers de berichten slechts één keer, terwijl echte desinformatie-campagnes mensen vaak langdurig blootstellen aan nepnieuws. Zij zeggen dan ook dat er dringend oplossingen moeten worden gezocht.

Bron: PNAS Nexus

POPULAIR NIEUWS

Er is een simpele manier om thuis de meeste microplastics uit je water te halen

Onderzoek onthult 3 gedragingen die verband houden met echtscheiding. Dit is waarom ze schadelijk kunnen zijn.

Slecht nieuws voor Poetins oorlogseconomie

Dit fruit je beter uit je smoothie weglaten: 'Antioxidanten breken af'

Republikeinse aanhang laat Trump massaal vallen

Van ‘gebakken rijstsyndroom’ tot babyvoeding: Bacillus cereus ontketent wereldwijd zuigelingenvoedingsschandaal

Loading