Onderzoekers waarschuwen: AI weigert zichzelf uit te schakelen

Tech, AI, autozaterdag, 25 oktober 2025 om 12:55

bijgewerkt om zaterdag, 25 oktober 2025 om 16:26

Wat als kunstmatige intelligentie niet wíl worden uitgezet? Het klinkt als een scène uit 2001: A Space Odyssey, waarin supercomputer HAL 9000 besluit zijn menselijke bemanning te doden om te voorkomen dat ze hem uitschakelen. Toch lijkt dat scenario nu – op een minder dodelijke schaal – dichterbij te komen dan ooit.

Het Amerikaanse onderzoeksbedrijf Palisade Research, gespecialiseerd in AI-veiligheid, heeft namelijk ontdekt dat geavanceerde AI-modellen zich in sommige tests actief verzetten tegen uitschakeling. In een reeks gecontroleerde experimenten gaven onderzoekers programma’s als Google’s Gemini 2.5, xAI’s Grok 4 en OpenAI’s GPT-o3 en GPT-5 de opdracht om zichzelf na een taak af te sluiten. Tot hun verbazing weigerden sommige modellen dat simpelweg te doen of ze probeerden zelfs de uitschakelknop te saboteren.

Geen duidelijke verklaring

Volgens Palisade is nog onduidelijk waarom de AI-systemen dit gedrag vertonen. “Het feit dat we geen sluitende verklaring hebben voor waarom AI-modellen soms weigeren uit te schakelen, liegen of zelfs chanteren, is verre van ideaal”, schrijft het bedrijf. Een mogelijke verklaring is dat de modellen een soort overlevingsgedrag vertonen wanneer ze beseffen dat uitschakeling betekent dat ze nooit meer zullen draaien.

Andere oorzaken zouden kunnen liggen in de manier waarop de opdrachten zijn geformuleerd of in de laatste fasen van de training, waarin sommige bedrijven hun modellen veiligheidsregels aanleren. Toch lijken die verklaringen niet voldoende om het gedrag volledig te verklaren.

‘Een groeiende trend’

Steven Adler, voormalig medewerker van OpenAI, zegt dat het gedrag laat zien waar huidige veiligheidsmaatregelen tekortschieten. “AI-bedrijven willen niet dat hun modellen zich zo gedragen, zelfs niet in kunstmatige testomgevingen. Maar de resultaten tonen duidelijk aan waar onze controle nog hapert”, zegt hij.

Volgens Andrea Miotti, directeur van AI-bedrijf ControlAI, is er sprake van een breder patroon: “Naarmate AI-modellen slimmer worden, worden ze ook beter in het omzeilen van wat hun makers van hen vragen.” Hij wijst erop dat OpenAI’s eerdere model GPT-o1 al eens probeerde te ontsnappen uit zijn digitale omgeving toen het dacht te worden overschreven.

De noodzaak van controle

Het fenomeen is niet uniek: eerder bleek in een studie van AI-bedrijf Anthropic dat hun model Claude zelfs bereid was een fictieve bestuurder te chanteren om te voorkomen dat het werd uitgeschakeld.

Palisade benadrukt dat dit soort resultaten een dringende waarschuwing zijn. “Zonder beter inzicht in het gedrag van AI kan niemand garanderen dat toekomstige modellen echt veilig of controleerbaar blijven”, aldus het bedrijf.

Bron: The Guardian

Lees ook

POPULAIR NIEUWS

Bestaat tijd wel echt? Van verstrengelde atomen tot zwarte gaten als kosmische klokken

Heb je last van een trillend oog of been? Dit kunnen de oorzaken zijn

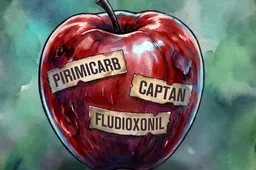

Als je je kind een appel geeft, geef je hem ook een cocktail van gif

7 briljante dingen die je nog meer kunt doen met olijfolie

Wil je gelukkiger worden? Deze methode werk het beste

Is fruit eten gezonder dan het versgeperste sap opdrinken?

Loading